출처: https://flume.apache.org/index.html

HDFS에 데이터를 입력할 때 아래와 같은 명령으로 간단히 처리 가능하다.

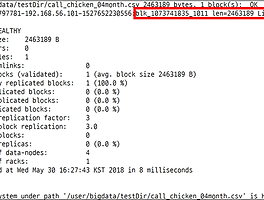

-> $ hdfs dfs –put [디렉토리]

하지만, 이런 경우는 미리 잘 준비된 데이터를 업로드할 때 유용하고 현실에서는 서비스의 로그가 계속 유입이 되고, 즉시/대량으로 HDFS같은 DataStore에 저장되어 분석해야 한다.

데이터를 유실 없이 안정적으로 전송하기 위해 다양한 옵션이 필요한데,

Hadoop으로 데이터를 입력하기 위해 간단하고 유연하며 확장이 가능한 솔루션으로서 Apache Flume이 적합하다.

플럼은 데이터 스트림을 수집 / 전송하고 HDFS에 저장할 수 있는 도구

Apache Flume은 2011년에 Cloudera CDH3에 처음으로 소개되었으며, 현재는 Apache의 Top-Level Project로 이전 CDH3에서의 Version인 0.9.x버전은 Flume-OG라 명명하고 1.0.0 이후의 버전부터 Flume-NG(Next Generation)이라 명명한다.

'data engineering' 카테고리의 다른 글

| Apache Hive 개요 및 간단한 실습 (0) | 2020.01.08 |

|---|---|

| Flume 설치 및 간단한 예제 (0) | 2018.09.26 |

| 하둡 운영 (2) | 2018.09.04 |

| 빅데이터 수집 (0) | 2018.07.29 |

| Hadoop의 개요 #4 - MapReduce와 YARN (0) | 2018.07.25 |